Nginx使用手册

本文最后更新于:2021年6月21日 上午

一、安装Nginx

Docker安装流程

docker pull nginx:1.10

docker run -p 80:80 --name nginx -v /mydata/nginx/html:/usr/share/nginx/html -v /mydata/nginx/logs:/var/log/nginx -d nginx:1.10

# 拷贝出容器中的配置文件

docker container cp nginx:/etc/nginx /mydata/nginx/

cd /mydata/nginx/

ls

mv nginx conf

docker stop nginx

docker rm nginx

# 再次运行容器,并关联配置文件

docker run -p 80:80 --name nginx -v /mydata/nginx/html:/usr/share/nginx/html -v /mydata/nginx/logs:/var/log/nginx -v /mydata/nginx/conf:/etc/nginx -d nginx:1.10二、Nginx概述

Nginx是一个web服务器和反向代理服务器,常用于正向代理、反向代理、负载均衡及动静分离等等。

- 占用内存小,可以实现高并发连接,处理响应快

- 配置简单,可以比较容易地实现反向代理和负载均衡

- 动态处理较差

| 作用 | 示例图 | 解释 |

|---|---|---|

| 正向代理 |  |

对客户端进行代理,比如日常使用的VPN就是正向代理类型。 |

| 反向代理 |  |

对服务器进行代理,客户端将请求发送给反向代理服务器,由反向代理服务器选择目标服务器处理请求。隐藏了真实服务器的IP地址。 |

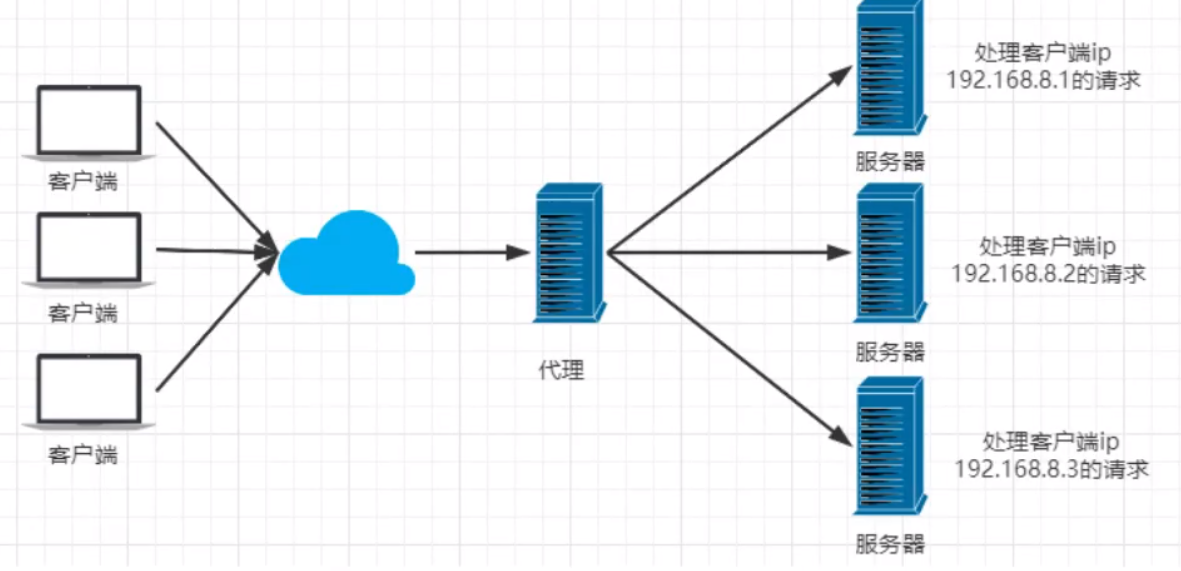

| 负载均衡 |  |

将原先集中到单个服务器上的请求,分发到多个服务器上。常见的分发算法有轮询、加权、IPHash等 |

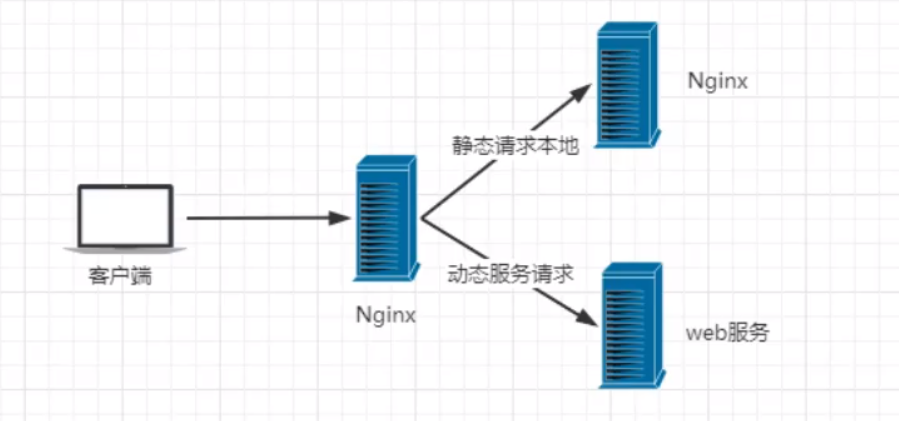

| 动静分离 |  |

分离不需要后台处理的静态资源和需要后台服务器处理的动态资源,以提高资源响应速度。 |

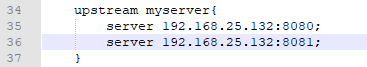

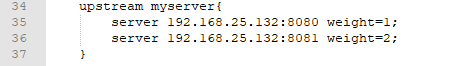

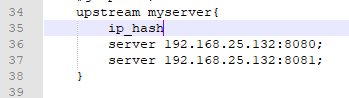

三、负载均衡的策略

- 轮训

- 加权:权重越来,被访问的概率就越高

- IP哈希:对用户的IP地址计算哈希值,根据哈希值分配服务器。使得来自同一个IP地址的访客固定访问同一个后端服务器,以解决session 共享等问题

- fair,按后端服务器的响应时间来分配请求,响应时间短的服务器优先被分配请求

四、配置文件解析

主要包含全局配置块、events块、http块等。

请求过来时,Nginx先根据listen和server_name匹配server块,再根据location条件匹配具体的location块.

location对用户请求的URL进行匹配,匹配成功后再进行响应的操作

# 优先级1,精确匹配。根路径

location =/ {

return 400;

}

# 优先级2,匹配以某个字符串开头。此处匹配以av开头的路径,区分大小写

location ^~ /av {

root /data/av/;

}

# 优先级3,区分大小写的正则匹配。匹配/media*****路径

location ~ /media {

alias /data/static/;

}

#优先级4 ,不区分大小写的正则匹配。所有的****.jpg|gif|png 都走这里

location ~* .*\.(jpg|gif|png|js|css)$ {

root /data/av/;

}

#优先7,通用匹配

location / {

return 403;

}详细nginx.conf

# 定义Nginx运行的用户和用户组

user www www;

# nginx进程数,建议设置为等于CPU总核心数.

worker_processes 8;

# 全局错误日志定义类型,[ debug | info | notice | warn | error | crit ]

error_log /var/log/nginx/error.log info;

# 进程文件

pid /var/run/nginx.pid;

# 一个nginx进程打开的最多文件描述符数目,建议与ulimit -n的值保持一致.

worker_rlimit_nofile 65535;

# 工作模式与连接数上限

events

{

# 参考事件模型,use [ kqueue | rtsig | epoll | /dev/poll | select | poll ]

use epoll;

# 单个进程最大连接数,默认为512

worker_connections 1024;

}

# 设定http服务器

http

{

include mime.types; #文件扩展名与文件类型映射表

default_type application/octet-stream; #默认文件类型

charset utf-8; #默认编码

server_names_hash_bucket_size 128; #服务器名字的hash表大小

client_header_buffer_size 32k; #上传文件大小限制

large_client_header_buffers 4 64k; #设定请求缓

client_max_body_size 8m; #设定请求缓

keepalive_timeout 65; # 连接超时时间,默认为75s,可以在http,server,location块。

autoindex on; # 显示目录,默认关闭

autoindex_exact_size on; # 显示文件确切大小,默认为on,单位是bytes

autoindex_localtime on; # 显示文件本地时间,默认为off,GMT时间;改为on后,显示的文件时间为文件的服务器时间

sendfile on; # 开启高效文件传输模式,sendfile指令指定nginx是否调用sendfile函数来输出文件,对于普通应用设为 on,如果用来进行下载等应用磁盘IO重负载应用,可设置为off,以平衡磁盘与网络I/O处理速度,降低系统的负载.注意:如果图片显示不正常把这个改成off.

tcp_nopush on; # 防止网络阻塞

tcp_nodelay on; # 防止网络阻塞

# FastCGI相关参数是为了改善网站的性能:减少资源占用,提高访问速度.下面参数看字面意思都能理解.

fastcgi_connect_timeout 300; ## 链接

fastcgi_send_timeout 300; ##读取 是指nginx进程向fastcgi进程发送request的整个过程的超时时间

fastcgi_read_timeout 300; ##发请求 是指fastcgi进程向nginx进程发送response的整个过程的超时时间

fastcgi_buffer_size 64k;

fastcgi_buffers 4 64k;

fastcgi_busy_buffers_size 128k;

fastcgi_temp_file_write_size 128k;

# gzip模块设置

gzip on; #开启gzip压缩输出

gzip_min_length 1k; #允许压缩的页面的最小字节数,页面字节数从header偷得content-length中获取.默认是0,不管页面多大都进行压缩.建议设置成大于1k的字节数,小于1k可能会越压越大

gzip_buffers 4 16k; #表示申请4个单位为16k的内存作为压缩结果流缓存,默认值是申请与原始数据大小相同的内存空间来存储gzip压缩结果

gzip_http_version 1.1; #压缩版本(默认1.1,目前大部分浏览器已经支持gzip解压.前端如果是squid2.5请使用1.0)

gzip_comp_level 2; #压缩等级.1压缩比最小,处理速度快.9压缩比最大,比较消耗cpu资源,处理速度最慢,但是因为压缩比最大,所以包最小,传输速度快

gzip_types text/plain application/x-javascript text/css application/xml;

#压缩类型,默认就已经包含text/html,所以下面就不用再写了,写上去也不会有问题,但是会有一个warn.

gzip_vary on;#选项可以让前端的缓存服务器缓存经过gzip压缩的页面.例如:用squid缓存经过nginx压缩的数据

#开启限制IP连接数的时候需要使用

#limit_zone crawler $binary_remote_addr 10m;

# 虚拟主机1的配置

server

{

# 监听端口

listen 80;

# 域名可以有多个,用空格隔开

server_name 127.0.0.1;

# HTTP 自动跳转 HTTPS

rewrite ^(.*) https://www.baidu.com;

deny 127.0.0.1; #拒绝的ip

allow 172.18.5.54; #允许的ip

}

upstream myserver {

server 127.0.0.1:8080;

server 192.168.24.189:8080 backup; #热备

}

# 虚拟主机2的配置

server

{

# 监听端口 HTTPS

listen 443 ssl;

server_name https://www.baidu.com; # 提高服务的域名主机名

root /data/www/; # 站点根目录

# 配置域名证书

ssl_certificate C:\WebServer\Certs\certificate.crt;

ssl_certificate_key C:\WebServer\Certs\private.key;

ssl_session_cache shared:SSL:1m;

ssl_session_timeout 5m;

ssl_protocols SSLv2 SSLv3 TLSv1;

ssl_ciphers ALL:!ADH:!EXPORT56:RC4+RSA:+HIGH:+MEDIUM:+LOW:+SSLv2:+EXP;

ssl_prefer_server_ciphers on;

index index.html index.htm index.php; # 默认首页文件

location ~ .*\.(php|php5)?$

{

fastcgi_pass 127.0.0.1:9000;

fastcgi_index index.php;

include fastcgi.conf;

}

# 配置地址拦截转发,解决跨域验证问题

location /oauth/{

proxy_pass https://localhost:13580/oauth/;

proxy_set_header HOST $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

}

# 图片缓存时间设置

location ~ .*\.(gif|jpg|jpeg|png|bmp|swf)$ {

expires 10d;

}

# JS和CSS缓存时间设置

location ~ .*\.(js|css)?$ {

expires 1h;

}

# 日志格式设定

log_format access '$server_name $remote_addr -$remote_user [$time_local] "$request"'

'$status $uptream_status $body_bytes_sent "$http_referer"'

'"$http_user_agent" "$http_x_forwarded_for" '

'$ssl_protocol $ssl_cipher $upstream_addr $request_time $upstream_response_time';

# 定义本虚拟主机的访问日志

access_log /var/log/nginx/access.log access;

# 设定查看Nginx状态的地址.StubStatus模块能够获取Nginx自上次启动以来的工作状态,此模块非核心模块,需要在Nginx编译安装时手工指定才能使用

location /NginxStatus {

stub_status on;

access_log on;

auth_basic "NginxStatus";

auth_basic_user_file conf/htpasswd;

#htpasswd文件的内容可以用apache提供的htpasswd工具来产生.

}

}

}五、解决前端跨域问题

- 添加请求头Access-Control-Allow-Origin 、Access-Control-Allow-Methods、Access-Control-Allow-Headers

- 对那些可能对服务器数据产生副作用的HTTP 请求方法,浏览器必须首先使用 OPTIONS 方法发起一个预检请求(preflight request),从而获知服务端是否允许该跨域请求。服务器确认允许之后,才发起实际的 HTTP 请求

# 跨域请求的接口是: http://www.test.com/exchangeApi/xxxx

server {

listen 80;

server_name test.com www.test.com;

root /data/web/homepage;

index index.html;

location ~ /exchangeApi/ {

add_header Access-Control-Allow-Origin *;

add_header Access-Control-Allow-Methods 'GET, POST, OPTIONS';

add_header Access-Control-Allow-Headers 'DNT,X-Mx-ReqToken,Keep-Alive,User-Agent,X-Requested-With,If-Modified-Since,Cache-Control,Content-Type,Authorization';

if ($request_method = 'OPTIONS') { # 发送预检请求

return 204;

}

....

}

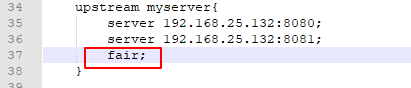

}六、Nginx高可用

通过安装keepalived和部署多台Nginx服务器来避免一台Nginx服务器挂了,整个Nginx服务崩溃。

[root@192 usr]# yum install keepalived -y

[root@192 usr]# rpm -q -a keepalived

keepalived-1.3.5-16.el7.x86_64

[root@192 keepalived]# cd /etc/keepalived

[root@192 keepalived]# vi keepalived.conf

global_defs {

notification_email {

acassen@firewall.loc

failover@firewall.loc

sysadmin@firewall.loc

}

notification_email_from Alexandre.Cassen@firewall.loc

smtp_server 192.168.25.147

smtp_connect_timeout 30

router_id LVS_DEVEL # 访问的主机地址

}

vrrp_script chk_nginx {

script "/usr/local/src/nginx_check.sh" # 检测文件的地址

interval 2 # 检测脚本执行的间隔

weight 2 # 权重

}

vrrp_instance VI_1 {

state BACKUP # 主机MASTER、备机BACKUP

interface ens33 # 网卡

virtual_router_id 51 # 同一组需一致

priority 90 # 访问优先级,主机值较大,备机较小

advert_int 1

authentication {

auth_type PASS

auth_pass 1111

}

virtual_ipaddress {

192.168.25.50 # 虚拟ip

}

}

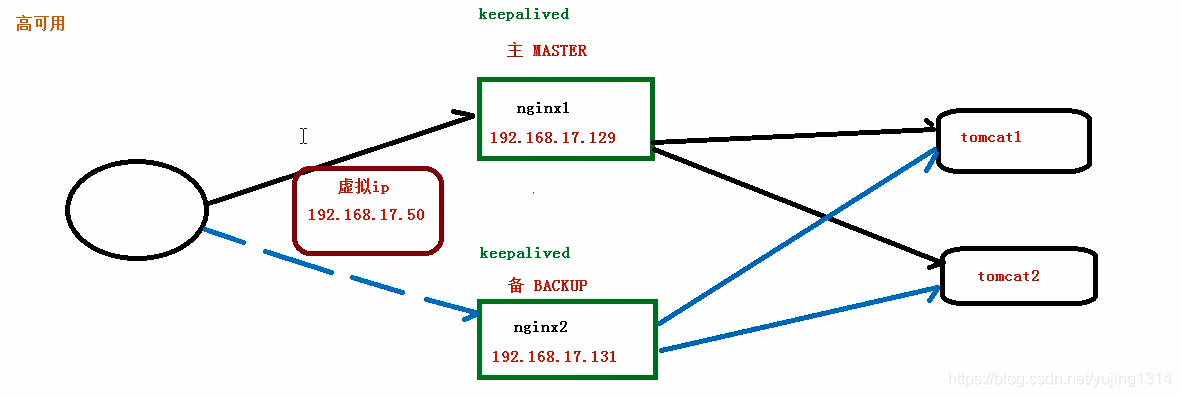

[root@192 sbin]# systemctl start keepalived.service一个Master进程管理者多个work进程,

为什么单线程的Nginx性能这么高?

- 主要是由于它采用AIO机制来响应请求

- Nginx有一个master进程及多个work进程:master进程进行收集、分发请求,每次一个请求过来,master就会拉起一个worker进程负责处理这个请求;但是worker进程并不是一直在处理,当处理到可能发生阻塞的地方,比如向上游(后端)服务器转发请求并等待返回,它就去处理别的事情了,等后台服务器返回响应,这个worker收到通知再回来继续做剩下的事情。相当于充分利用了等待时间

- 基于AIO机制处理请求,不会为每个请求分配CPU和内存资源,同时也节省了线程上下文切换的时间

Nginx优化

(1)调整worker_processes,尽量和CPU数量一致

(2)最大化worker_connections,即1024

(3)启用GZIP,压缩文件大小,提高响应速度

(4)为静态资源开启缓存

location ~* .(jpg|jpeg|png|gif|ico|css|js)$ {

expires 365d;

}(5)调整Timeout,避免频繁开启和关闭连接

参考

本博客所有文章除特别声明外,均采用 CC BY-SA 4.0 协议 ,转载请注明出处!